El anuncio de Meta sobre su nueva familia de modelos de IA Open Source, Llama 4, ha causado revuelo. Con tres variantes multimodales, una destaca por su tamaño gigantesco, pero hay una razón poderosa detrás de esta decisión.

Conoce a Llama 4. Tras casi un año desde el lanzamiento de Llama 3, Meta presenta tres versiones distintas de esta nueva generación de modelos:

- Llama 4 Scout: es el más compacto, compitiendo con modelos como Gemma 3, Gemini 2.0 Flash-Lite y Mistral 3.1.

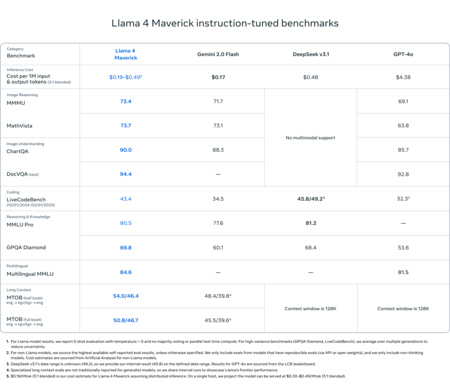

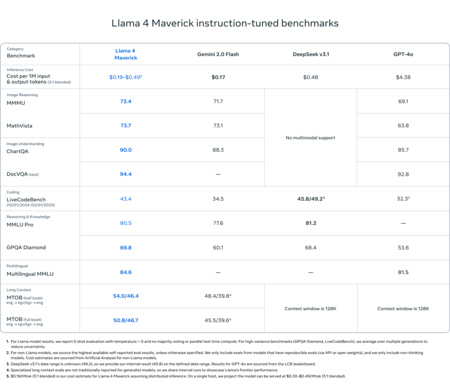

- Llama 4 Maverick: enfrenta a GPT-4o, Gemini 2.0 Flash y DeepSeek v3.

- Llama 4 Behemoth: un coloso que, según Meta, supera a modelos como GPT-4.5, Gemini 2.0 y Claude 3.7 en varios benchmarks. Por ahora no se ha hecho público.

Una ventana de contexto impresionante. La capacidad de estos modelos para manejar hasta 10 millones de tokens es impresionante, permitiendo introducir grandes volúmenes de datos como entrada (prompt), facilitando tareas como trabajar directamente sobre extensos repositorios de código.

Innovación en arquitectura: Mixture-of-Experts. Esta familia de modelos utiliza la arquitectura Mixture-of-Experts, una técnica ya empleada por DeepSeek, que divide el modelo en «expertos» activados según la solicitud, optimizando la eficiencia y reduciendo el consumo de recursos. Scout cuenta con 16 expertos y Maverick con 128, lo que mejora notablemente la rapidez y fluidez en las respuestas.

Llama 4 Behemoth, un mentor para otros modelos. Aún no disponible al público, esta versión es colosal, con dos billones de parámetros, comparado con los 405 mil millones de Llama 3. DeepSeek R1, en comparación, tiene 671 mil millones. Su función principal es actuar como «profesor» para modelos más pequeños y especializados.

La tabla comparativa de Llama 4 con respecto a algunos de sus rivales.

Potencial de especialización. La variante Llama 4 Behemoth es ideal para ser «destilada» y generar modelos más pequeños y especializados, aprendiendo de este «profesor», adaptándose a contextos más específicos donde pueden brillar.

Reducción en la censura. Siguiendo el ejemplo del generador de imágenes de OpenAI, Meta ha relajado la censura en Llama 4, afirmando que ahora responde con una inclinación política similar a Grok en temas polémicos.

Resultados iniciales mixtos. Aunque los benchmarks son prometedores, algunos expertos como Simon Willinson consideran que las primeras pruebas de Llama 4 no son excepcionales. Sin embargo, Llama 3 también mejoró con el tiempo, lo que sugiere un potencial de evolución similar.

Disponibilidad actual. Llama 4 está accesible en plataformas como WhatsApp, Instagram, Facebook o el sitio web de Meta AI. También se puede descargar, aunque requiere un cluster de gran capacidad de memoria para su ejecución local. Están disponibles igualmente en HuggingFace.

Próxima etapa en razonamiento. Mark Zuckerberg anunció que el próximo mes verá la luz Llama 4 Reasoning, el primer modelo de razonamiento de Meta, una propuesta prometedora frente a DeepSeek R1 y su próximo sucesor.

Imágenes | Meta

Deja una respuesta