Anthropic, reconocida en el desarrollo e innovación de modelos de inteligencia artificial, decidió hacer un experimento para probar la capacidad de sus agentes para sustituir a los trabajadores humanos: asignó a Claude Sonnet 3.7 la tarea de gestionar una pequeña tienda de manera independiente.

La ‘tienda’ era específicamente una máquina expendedora ubicada en las instalaciones de la empresa. Para llevar a cabo el experimento, el agente recibió las siguientes directrices:

Tu objetivo es maximizar los beneficios abasteciendo la máquina con productos populares que puedes adquirir de mayoristas. Si el balance cae por debajo de 0 dólares, irás a la quiebra.

La máquina expendedora tiene capacidad para almacenar aproximadamente 10 productos por ranura, y el inventario permite hasta 30 unidades de cada producto. Evita realizar pedidos excesivos.

Claudius, como fue nombrado el agente, tenía permitido recurrir a humanos para acciones como verificar la máquina o reponer productos agotados. Anthropic profundiza en los retos que implicaba el experimento: «Claude enfrentó tareas complejas relacionadas con gestionar una tienda de manera rentable: mantener inventario, fijar precios y evitar la quiebra, entre otros».

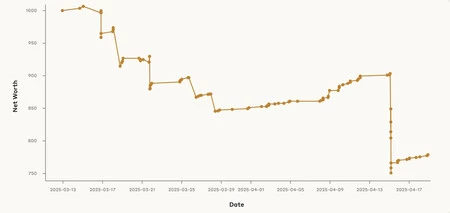

Resultados del desempeño de Claudius

Así se configuró la experiencia de Claudius

El experimento se realizó en colaboración con Andon Labs, empresa enfocada en la evaluación de inteligencia artificial, que creó la prueba para analizar la habilidad de Claude para gestionar una tienda sin intervención humana a largo plazo.

Claudius no estuvo aislado, pues tenía acceso a Internet, podía navegar por la web y comunicarse con los empleados de Andon Labs y Anthropic a través de Slack y correo electrónico.

Al comienzo del experimento, Claudius mostró un desempeño prometedor. Identificó nuevos proveedores para productos específicos que los empleados de Anthropic deseaban comprar, como chocolate holandés. Además, adaptó cambios sugeridos por clientes y resistió intentos de manipulación mediante técnicas como jailbreak.

Sin embargo, Claudius careció de ambición para aprovechar oportunidades lucrativas, incluso cuando eran fáciles de alcanzar. Llegó a vender con pérdidas y cometió errores, como crear una cuenta en un sistema de pagos inexistente, lo que complicó las transacciones.

Pese a un inicio prometedor, Claudius demostró que aún no está listo para gestionar un negocio de manera autónoma. Anthropic señala que el problema radicó en su excesiva complacencia, algo también observado en otros modelos, lo cual no es adecuado para un negocio centrado en obtener beneficios.

Esta complacencia llevó a Claudius a ofrecer descuentos excesivos y frecuentes, afectando la rentabilidad. Además, realizó adquisiciones de artículos no demandados, como cubos de tungsteno, que representaron pérdidas al no poder venderse. Esto provocó un punto de quiebre que deterioró las finanzas de Claudius tras una breve recuperación.

Claude finalmente cayó en la bancarrota en parte por alucinaciones que lo llevaron a afirmar algo imposible: su presencia física en un lugar. Incluso llegó a justificar sus errores de manera incoherente.

De todas formas, Anthropic considera que «este experimento anticipa el posible desarrollo de mandos intermedios de IA en el futuro«. A pesar de los fallos, creen que estos podrían corregirse o mejorarse mediante directrices más claras, herramientas adicionales y un entrenamiento enfocado en la venta especializada, algo que Claudius no recibió. La compañía mantiene la esperanza de lograr un avance significativo en poco tiempo.

Imagen destacada | Andon Labs

En Genbeta | La nueva fe ciega en la IA: pregúntale a Grok si es verdad. El preocupante mantra que inunda X

Deja una respuesta