Los modelos de inteligencia artificial siempre son una fuente de curiosidad al someterse a exámenes desafiantes que ponen a prueba el intelecto humano. En España, el examen MIR es uno de esos desafíos, ya que abre las puertas a la formación de especialistas médicos. ¿Cómo se desempeñan las IA en este examen?

Un MIR particularmente retador. Para el 2025, los expertos afirman que el MIR ha sido especialmente complejo. Se critica con frecuencia que el examen se centra en patologías poco comunes, difíciles incluso para médicos experimentados.

Evaluando las capacidades de las IA. Julián Isla, del equipo de IA en Microsoft, compartió en LinkedIn su experiencia poniendo a prueba varios modelos avanzados de IA con las preguntas del examen. Este examen incluye 210 preguntas de opción múltiple con cuatro opciones cada una. Algunas de estas preguntas incluyen imágenes médicas y cubren distintas especialidades.

Fuente: Joaquín Isla (LinkedIn)

Diversas versiones. Utilizaron la Versión 0 del examen junto con las imágenes incluidas en el cuadernillo. Las respuestas de todas las versiones se publicaron el lunes en el Ministerio de Sanidad y están disponibles en plataformas como iSanidad, donde se pueden consultar las de la Versión 0.

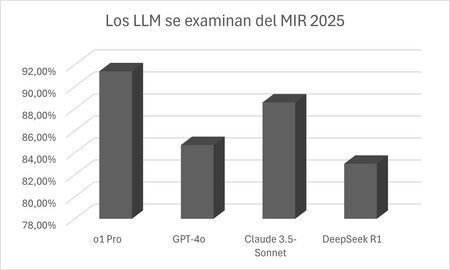

OpenAI o1 Pro, sobresaliente. El modelo de razonamiento o1 en su versión Pro logró un impresionante 91,7% de aciertos, fallando solo 17 de las 210 preguntas, de las cuales solo dos involucraban imágenes. Según Isla, incluso los especialistas tendrían dificultades para responder algunas de estas preguntas.

Claude y GPT-4o operan sin necesidad de razonamiento profundo. El segundo mejor fue Claude 3.5 Sonnet, con un 88,5% de aciertos, sobresaliendo pese a no ser un modelo de razonamiento. GPT-4o también mostró un alto rendimiento con un 84,7% de aciertos.

DeepSeek R1, notable alto. DeepSeek R1 logró un 83,8% de aciertos, fallando en 34 preguntas. Este resultado muestra que, aunque inferior a o1 Pro, sigue siendo sobresaliente. Además, sus desarrolladores destacan que requiere una menor inversión en su entrenamiento.

No dejan preguntas sin responder. Al ser un examen tipo test, se penalizan las respuestas incorrectas, lo que afecta a estos modelos que responden sistemáticamente, estén seguros o no. Julián Isla también destacó la notable mejora en preguntas con imágenes, un gran avance respecto al año anterior.

La ventaja de la IA: su vasto conocimiento. La ventaja indudable es que estos modelos están entrenados con millones de datos, incluidos conocimientos médicos, lo que les permite consultar este extenso «repositorio» para responder. Es como si pudieran utilizar una gigantesca chuleta, algo que los estudiantes humanos no tienen permitido durante el examen.

Imagen | Xataka con Freepik Pikaso

Deja una respuesta