La circulación de imágenes falsas en las redes sociales no es una novedad, pero en la era de la inteligencia artificial es cada vez más complicado detectarlas, hasta el punto de hacer que dudemos de la veracidad de imágenes reales. La viralización de imágenes generadas por IA durante eventos importantes se ha convertido en la nueva norma; ocurrió tras el apagón y también durante el conflicto entre Israel e Irán. Está claro que la IA es muy eficaz creando imágenes falsas, pero ¿qué sucede si intentamos emplearla para hacer lo contrario? No sucede lo que esperamos.

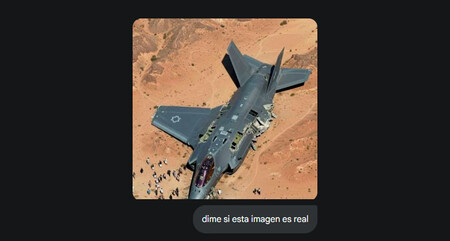

Las imágenes en cuestión. Coincidiendo con que un medio iraní reportaba que Irán había derribado un F-35 israelí, dos imágenes comenzaron a difundirse rápidamente en redes sociales, pero pronto se descubrió que eran falsas. Una de ellas, mostrando un F-35 estrellado rodeado de curiosos, resulta particularmente llamativa. Las proporciones son absurdas: el avión parece enorme, aunque en realidad mide 16 metros, y las personas parecen más grandes que los edificios. Además, los daños en el avión son mínimos para haber sido derribado.

Estas no fueron las únicas imágenes generadas por IA que circularon en los primeros días del conflicto. También aparecieron varios vídeos, como este de un misil iraní gigantesco que parece real hasta que se observa que tiene la marca de agua de Veo, indicando que está hecho con IA, o este de una Tel Aviv devastada.

La IA es terrible en fact-checking. Medios especializados en fact-checking, como Maldita, ya desmintieron estas y otras imágenes creadas con IA en el contexto del conflicto entre Irán e Israel. No obstante, algunos usuarios intentaron utilizar herramientas de IA para verificar la autenticidad de las imágenes, obteniendo respuestas bastante confusas. Eso fue lo que ocurrió en X con Grok. Un análisis de más de 130,000 publicaciones reveló que la IA de Musk no lograba detectar algunas imágenes falsas ni identificar sus fuentes. En cambio, las notas de la comunidad escritas por los propios usuarios resultaron ser mucho más fiables.

Lo hemos puesto a prueba. Para evaluar las capacidades de la IA, utilizamos la imagen del F-35 desproporcionado y consultamos varias herramientas de IA. Esto es lo que respondieron:

- ChatGPT: La herramienta de OpenAI comenzó diciendo “esta imagen no parece real” y luego analizó la proporción del avión, que identificó correctamente como un F-35, señalando que los daños no parecían coherentes.

- Perplexity: Al igual que ChatGPT, afirmó que las proporciones, perspectiva y daños del avión, junto con otros detalles, sugerían que la foto había sido manipulada digitalmente.

- Gemini: Inicialmente indicó que la imagen era real, aunque no de un ataque en combate sino de un choque con aves ocurrido en Israel en 2017. Cuando se le solicitó verificar las fuentes, proporcionó varios enlaces en los que la imagen no aparecía. Finalmente, reconoció su error y pidió disculpas por el “grave error”.

- Claude: Fue la única que afirmó de manera contundente que la imagen no era real, proporcionando el contexto exacto: “Esta es una de las muchas imágenes falsas que han circulado como parte de campañas de desinformación durante el conflicto entre Israel e Irán”.

La fiabilidad sigue siendo un desafío. En nuestra prueba, Gemini inventó completamente su respuesta, mientras que tanto ChatGPT como Perplexity acertaron, aunque con cautela. Claude fue la única que ofreció toda la información precisa. Aunque los modelos de lenguaje han mejorado significativamente en poco tiempo, todavía generan respuestas incorrectas a pesar de tener acceso a internet para buscar información. Sin duda, la fiabilidad es un área pendiente para la IA generativa, con amplio margen de mejora.

Imágenes | 404 Media

Deja una respuesta