El renombrado psicólogo suizo Jean Piaget definió la inteligencia de una manera particularmente fascinante: «la inteligencia es lo que usas cuando no sabes qué hacer». Esta perspectiva puede ser esencial para una nueva forma de evaluar el potencial de la inteligencia artificial (IA), una que involucra poner a la IA a jugar Pokémon.

Evaluando la inteligencia artificial Existen varias pruebas actuales para medir las habilidades de la IA en resolver problemas científicos, matemáticos o de programación. Estas evaluaciones son útiles para cuantificar el avance de estos modelos, pero una propuesta distinta sugiere evaluar esta capacidad de la IA haciéndola jugar Pokémon.

El comienzo de Claude. El equipo de Anthropic tuvo la idea de probar su modelo de IA, Claude 3.7, jugando Pokémon Rojo. Utilizaron su herramienta de navegación automática para observar cómo manejaba el juego. Crearon un canal de Twitch y hay un seguimiento de su progreso en Reddit.

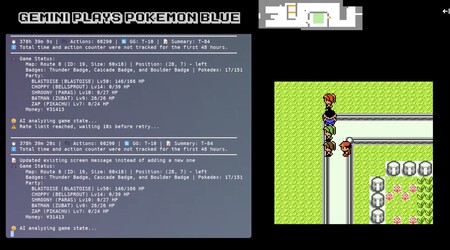

El turno de Gemini Pro. Un desarrollador sin conexión con Google extendió la idea utilizando el modelo Gemini Pro 2.5 Experimental. En su canal de Twitch, se exhibe una partida de Pokémon Azul en un emulador de Game Boy Advance.

¿Quién lleva la delantera? Por el momento, Gemini Pro 2.5 Experimental parece tener un mejor desempeño. A Claude le ha resultado complicado en ciertas fases, lo que le ha obligado a reiniciar sus partidas. Gemini, por otro lado, avanza con menos obstáculos, aunque su enfoque de juego difiere y utiliza un minimapa para compensar sus limitaciones de navegación automática.

La elección de Pokémon para la Game Boy. La versión de Pokémon para la Game Boy Advance es ideal para estos experimentos debido a varias razones. Como es un juego por turnos, brinda a la IA la posibilidad de «reflexionar» sobre cada movimiento. Además, su simplicidad gráfica facilita que estos modelos interpreten lo que ocurre en pantalla sin requerir muchos recursos.

Un benchmark revelador. Este método de evaluación de la inteligencia de una IA puede aportar más información que las pruebas tradicionales de matemáticas o programación. Mientras un niño de 10 años puede aprender rápidamente a manejar una Nintendo Switch, las IA enfrentan desafíos únicos, frecuentemente llevando a cabo acciones incorrectas.

Evitar la memorización. Muchas evaluaciones actuales de IA se enfocan en la «memoria» del modelo. A menudo, resuelven problemas al acceder a su base de datos entrenada o replicar soluciones previas. Esta nueva metodología demanda que las IA demuestren una verdadera capacidad de adaptación.

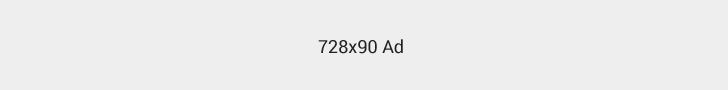

ARC-AGI y el clásico Snake. En febrero, la ARC Prize Foundation experimentó con otro videojuego, una versión del conocido Snake, enfrentando diversos modelos de IA para estudiar su comportamiento. Los modelos de razonamiento destacaron, llevándose el 78% de las victorias, resaltando la importancia de estos videojuegos para futuros desarrollos en IA.

Adapción y aprendizaje en IA. Estos benchmarks ayudan a evaluar si una IA puede adaptarse y superar nuevos desafíos. Empresas como DeepMind han estado explorando este enfoque con varios de sus desarrollos, y representa una prometedora oportunidad para quienes trabajan en el desarrollo de modelos de IA.

Deja una respuesta