La historia de Google con las gafas tecnológicas sigue vigente. Lejos de haber sido archivada, la compañía ha vuelto a traerlas al frente. Y lo hace con un proyecto que rescata un nombre familiar: Project Aura. Aunque ya habíamos escuchado de él en los días de las Google Glass, que terminaron en el olvido tecnológico, esta renovación trae una visión completamente distinta.

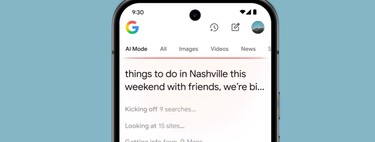

En el Google I/O 2025, evento que también presentó innovaciones como AI Mode y Beam, Google desveló en vivo el avance de sus nuevas gafas de realidad mixta. Esta iniciativa, en colaboración con Xreal, busca integrar la experiencia Android con el ecosistema XR, ofreciendo naturalidad, contexto y respuestas en tiempo real.

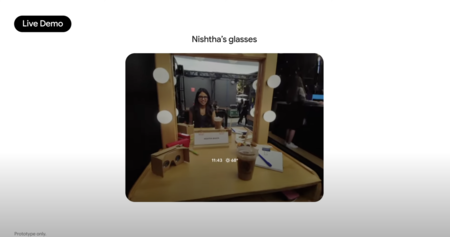

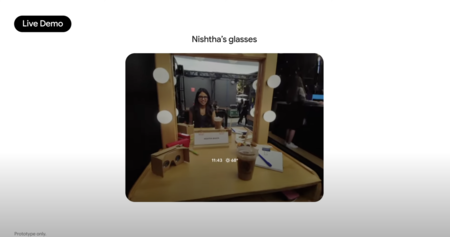

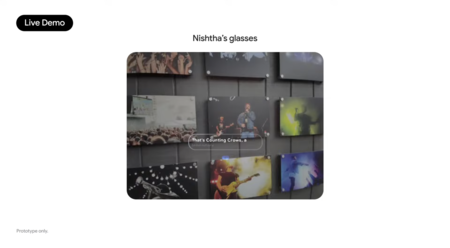

Un despliegue en vivo, sin artificios. Todo comenzó cuando Shahram Izadi, cabeza del departamento de dispositivos, formuló una pregunta al público durante un video en YouTube: “¿Quién está listo para ver una demostración anticipada de las gafas Android XR?” La respuesta vino desde detrás del escenario. Nishtha Bhatia, integrante del equipo, se presentó de manera remota y comenzó a demostrar el funcionamiento real de las gafas.

Lo primero que observamos fue una interfaz sobrepuesta en tiempo real sobre el entorno. Gracias a la cámara integrada, las gafas proyectaban lo que había frente a ellas mientras Bhatia recibía mensajes, escuchaba música, verificaba direcciones o interactuaba con Gemini, el asistente de voz, todo a través de comandos verbales. Sin necesidad de sacar el móvil o presionar algún botón.

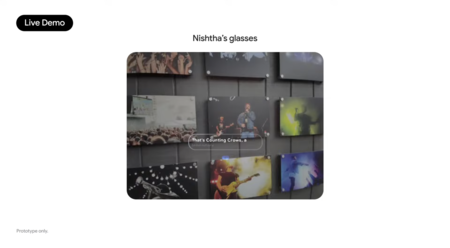

Uno de los momentos más sobresalientes de la demostración fue cuando se pudo preguntar cuál era la banda autora de una pintura observada. Gemini respondió, aunque con algunos retrasos debido a problemas de conexión. La función de reproducción de una canción en YouTube Music también se activó sin intervención manual, siendo todo capturado en la imagen compartida en tiempo real.

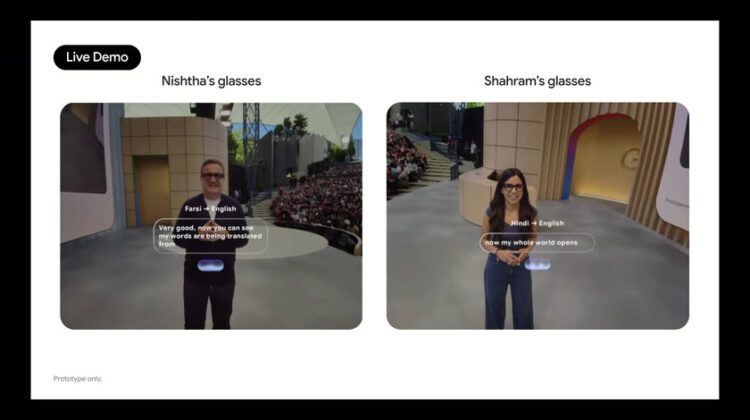

Traducción simultánea y un pequeño contratiempo en el escenario. La prueba culminante fue un diálogo entre Izadi y Bhatia en diferentes idiomas. Ella habló en hindi y él en farsi. Las gafas, con la ayuda de Gemini, proporcionaron una traducción en tiempo real. Aunque el sistema funcionó adecuadamente al inicio, los responsables decidieron cortar la demo al detectar un fallo.

A pesar del pequeño contratiempo, el mensaje fue contundente: Google está decidido a reconquistar el terreno de las gafas conectadas, esta vez apoyándose en un planteamiento más consolidado, dentro de su ecosistema de servicios, con Gemini y colaboraciones clave en el ámbito de la realidad extendida. La diferencia ahora radica en el enfoque: experiencias tangibles, en tiempo real, sin excesos ni promesas a futuro.

Imágenes | Google

Deja una respuesta